La inteligencia artificial generativa (IAG) ya forma parte del ciclo de vida de la investigación: ayuda a generar, estructurar y organizar textos; a crear imágenes y vídeos; a resumir evidencia; programar e incluso a generar nuevas hipótesis. Pero esta realidad también exige prudencia y unas normas de uso responsable. El GAMER Statement propone una lista de comprobación de nueve ítems para declarar y auditar el uso de herramientas generativas en investigación médica1. En Atención Primaria (AP) este estándar es especialmente necesario: trabajamos con datos muy sensibles, longitudinales y biográficos, tomando decisiones compartidas bajo incertidumbres, y cualquier opacidad metodológica erosiona la confianza. La IAG se caracteriza por generar texto nuevo, pero los modelos predicen en sus respuestas aquello que es probable, y no necesariamente aquello verdadero. A pesar de ofrecer resultados convincentes, estos pueden ser incorrectos, inventar referencias o sostener resultados engañosos fundamentados en bases de datos sesgadas, como ya se ha descrito recientemente2.

Las recomendaciones sobre el uso de IAG en las publicaciones es dispar: algunas se limitan a pedir una declaración general, rechazando autorías que se atribuyan a la IA; otras exigen una declaración con detalles técnicos trazables3, reinando la heterogeneidad editorial en las secciones de instrucciones a autores4. GAMER no prohíbe la IAG, pero exige transparencia sistemática y verificable, en la línea de propuestas recientes para un uso responsable de herramientas generativas en investigación5.

GAMER se desarrolló mediante dos rondas Delphi: 51 expertos de 26 países con perfiles clínicos, metodológicos, éticos, tecnológicos y editoriales. El resultado es aplicable a cualquier tipo de estudio y cualquier fase del proyecto (diseño, recolección de datos, análisis y redacción). Se centra en herramientas genuinamente generativas (modelos de lenguaje, visuales o multimodales) y no regula otros tipos de herramientas no generativas como buscadores o traductores. Las recomendaciones incluyen un checklist con definiciones y explicaciones para facilitar su aplicación. Y este enfoque se agradece, porque las guías de comprobación deben mejorar su reproducibilidad y rendición de cuentas, pero no a costa de añadir burocracia6.

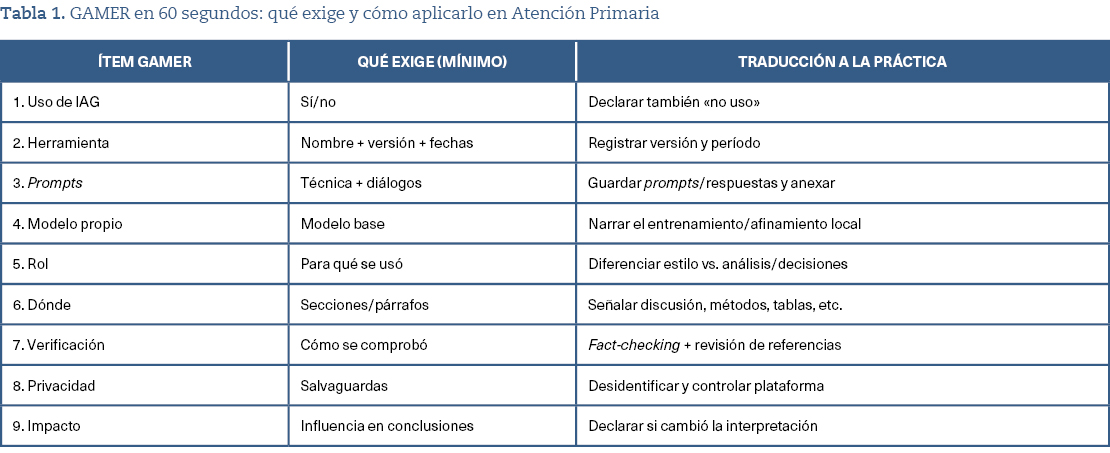

Los nueve ítems GAMER

GAMER se concreta en nueve requisitos completamente aplicables a cualquier ámbito de investigación (tabla 1), como en AP:

- Declaración general de uso: indicar si se usó o no IAG en cualquier paso del estudio o manuscrito.

- Especificación de herramienta y período: nombre, versión o fecha de lanzamiento, período exacto de uso y, cuando sea posible, si se utilizó interfaz y/o parámetros relevantes.

- Prompting y trazabilidad: describir técnicas de prompting y, cuando sea posible, aportar los prompts y respuestas no editadas como material suplementario.

- Modelos nuevos o ajustados: si se entrenó o afinó un modelo generativo, declarar el modelo original y su versión.

- Rol de la IAG en todas las fases: detallar para qué se usó (ideación, protocolo, análisis, generación de código, redacción, tablas o figuras).

- Localización en el manuscrito: señalar secciones o párrafos con contribución de IAG.

- Verificación del contenido: explicar cómo se verificó y, si fue necesario, se corrigió lo generado; siempre recordando que la responsabilidad última sigue siendo humana3.

- Privacidad y confidencialidad: describir salvaguardas para proteger datos durante el uso de IAG; en nuestro ámbito exige procesos de anonimización, seudononimización, y control de plataformas7.

- Impacto en conclusiones: declarar si el uso de IAG influyó en la interpretación o en las conclusiones.

La aportación de GAMER en AP nos obliga a diferenciar usos de bajo riesgo (p. ej., corrección de estilo) de usos con capacidad de alterar resultados (p. ej., generación de código, extracción automatizada de datos, o síntesis analítica). y añade trazabilidad cuando la IAG participa en la construcción del manuscrito. En términos operativos, GAMER invita a planificar el uso de IAG antes de escribir: decidir qué tareas se permitirán (y cuáles no), quién revisará las salidas, dónde se archivarán prompts y respuestas, y cómo se protegerán los datos. En estudios con historias clínicas o entrevistas, el checklist es útil como recordatorio de «líneas rojas»: nunca introducir información identificable y documentar las salvaguardas.

Implicaciones prácticas para autores, revisores y editores

Para los investigadores, GAMER introduce hábitos de buenas prácticas: registrar versiones, conservar prompts, archivar respuestas, documentar verificaciones y definir qué datos pueden entrar (y en qué entorno). En proyectos con historias clínicas electrónicas, esto debe traducirse en declarar los procedimientos de anonimización o seudononimización con herramientas aprobadas institucionalmente y con la necesaria aprobación de los comités de ética, los cuales (dicho sea de paso), deberán ser competentes en saber evaluar el uso de modelos de IAG. Para revisores y editores, el checklist contribuye a despejar la duda («¿Se usó IA?») en preguntas verificables («¿Qué modelo?, ¿qué prompts?, ¿cómo se comprobó?») aplicando criterios consistentes: solicitar el checklist cumplimentado y exigir una trazabilidad proporcional al riesgo.

GAMER no sustituye guías específicas ya existentes tales como TRIPOD+AI8 (que declara el uso transparente de modelos de predicción clínica que usan aprendizaje automático/IA), CONSORT‑AI9 (para ensayos clínicos que usan IA) o DECIDE‑AI (sistemas de apoyo a la decisión con IA)10. Lo que hace GAMER es complementarlas, ofreciéndose como un denominador común amigable cuando usemos IAG en cualquier etapa de la investigación. No obstante, el nivel de exigencia irá en aumento, como lo demuestra la aparición de guías centradas en grandes modelos de lenguaje como TRIPOD‑LLM11.

En AP ya convivimos con chatbots. Comparativas entre actuaciones de médicos frente a chatbots a preguntas o situaciones clínicas están demostrando potencialidades que nos obligan a discutir sobre seguridad, sesgos y adecuación clínica y contextual12,13. En contraposición a alguna proclama política, la IAG no sustituirá a los profesionales: y mucho menos a las médicas y los médicos de familia, en cuyo día a día la creatividad y la interacción son difícilmente sustituibles. Sin embargo, los profesionales que utilicen correctamente la IAG sí podrían reemplazar en el futuro a aquellos que no la usen. Y en el ámbito de la publicación científica ocurre algo similar: la IAG puede elevar la calidad y la eficiencia, pero solo si se hace de forma visible, auditable y responsable. En cualquier ámbito de investigación y publicación, la inclusión de una lista de comprobación como GAMER nos ofrecerá un estándar mínimo de buenas prácticas y transparencia: una decisión de integridad personal e institucional para quienes la adopten.